写在前面

关于GPT的内部细节和技术架构,OpenAI一直保持相对保密。本文基于官方博客和公开评论资料,对GPT的技术发展进行推测,仅为一家之言,如有偏颇,敬请指正。

前chatGPT时代

在chatGPT之前,语言模型经历了几个重要的发展阶段:

BERT (Bidirectional Encoder Representations from Transformers): 由Google在2018年发布,这种双向模型首次利用了Transformer架构进行深度语义理解,使得在自然语言处理任务上取得了突破性进展。

Transformer架构: 于2017年由Vaswani等人提出,是一种基于注意力机制(Attention Mechanism)的架构,彻底改变了语言模型的构建方式。它以更高的并行性和更少的训练时间,取代了传统的递归神经网络(RNN)和长短期记忆网络(LSTM)。

GPT系列: GPT-2于2019年发布,展示了大规模预训练的语言模型在生成自然语言文本方面的潜力。GPT-3进一步扩大了模型的规模和数据量,增强了模型的理解和生成能力。

chatGPT的诞生

ChatGPT的核心是在大规模预训练模型基础上,通过强化学习人类反馈(RLHF),使模型在对话数据集和用户反馈的指导下,逐步优化,最终形成一个更适合人机对话的通用语言模型。利用强化学习技术,ChatGPT能够在生成过程中逐渐偏向于更符合人类交互的模式,增强与人类的互动体验。

GPT-4o的改进

与chatGPT相比,GPT-4o在多模态输入和输出上有了显著的提升。GPT-4o不仅能够处理文本,还能生成和理解音频、图像和视频。这种多模态能力使其在通信形式和使用场景上更加广泛。

此外,GPT-4o优化了自然互动能力和上下文理解能力,使得模型能在更长、更复杂的对话中保持更高的准确性和连贯性。它在推理、适应性和用户个性化交互方面表现出更强的能力。

GPT-o1的出现

GPT-o1的推出是为了解决GPT-4o在复杂任务上表现不佳的问题,即模型容易产生“幻觉”或不准确的回答。GPT-o1引入了一个新范式,即“过程证明”,来提升模型在复杂任务中的表现。

过程证明的思想

当人类无法直接得出答案时,通常会依赖经验或直觉,导致可能出现不可靠的猜测。因此,为了提高答案的可靠性,人类往往需要“过程证明”,即给出详细的推理步骤,以确保每个步骤的逻辑性和正确性。类似地,在大模型中,我们可以通过**思维链路(Chain of Thought, CoT)**的形式,引导模型给出详细的推理过程。

在传统LLM中,研究者通常通过提示工程(Prompt Engineering)来引导模型逐步给出中间步骤,从而得到更为可靠的结果。OpenAI的GPT-o1则是将这种引导思维过程的做法直接融入到模型训练中,通过强化学习来内化这种推理链路的生成【1】。

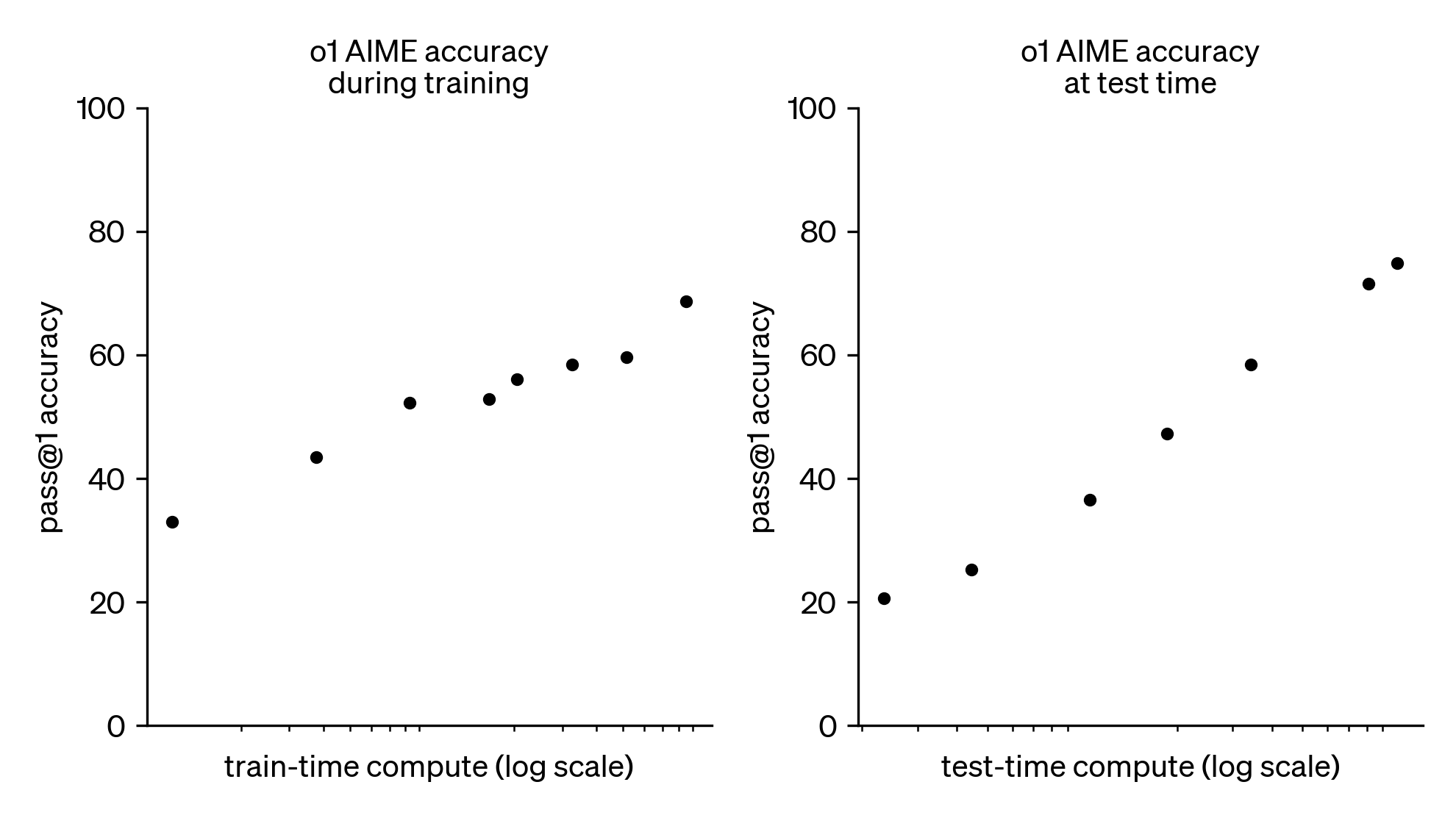

test-time compute的幂律性

OpenAI发现,在推理阶段(Inference)给予模型更多时间进行思考,其表现将随着思考时间的对数增加呈线性增长。这一认知颠覆了以往通过增加训练量和数据量来提升模型表现的传统范式【1】。

使用RL将prompt内化

虽然提示工程能引导LLM进行CoT,但将这种过程集成到训练阶段显然更为有效。OpenAI通过强化学习对思维过程进行评价和反馈,以优化模型的推理能力。可以大胆推测,模型的训练数据可能包含了大量由人类生成的带过程的语料,甚至可能包括各种比赛和论文中的问题和论证过程。

思考,快与慢

在AI领域,内在的思考过程通常被称为system1,而直觉性的快速猜测被称为system2。GPT-o1的“过程证明”理念有效地将“慢思考”集成到训练中,使模型的推理能力得到显著提升。未来,模型可能会更全面地掌握人类的meta-learning能力,逐渐迈向通用人工智能。

代价

引入“过程证明”也带来了性能上的挑战,如计算成本增加和响应速度变慢,可能不适合某些需要快速决策的应用场景。另外,在非严谨性的创作任务中,过度强调逻辑可能反而压制了模型的创造力【2】。

总结

GPT-o1通过“过程证明”这一新范式,在解决复杂逻辑任务方面展示了显著的性能提升。这一进步不仅改善了模型的准确性和可靠性,还引发了关于AI未来发展的更广泛讨论。然而,这种方法也带来了计算资源和响应速度上的挑战,需要在实际应用中权衡使用。

参考文献: